이 논문은 ICLR 2019 에 accept된 논문으로 Oral paper로 선정되었다.

https://arxiv.org/pdf/1811.12231.pdf

저자 : Robert Geirhos Patricia Rubisch Claudio Michaelis Matthias Bethge∗ Felix A. Wichmann∗ Wieland Brendel∗

1. Motivation

texture vs. shape

CNN은 object shape의 representation을 학습하는 것으로 생각되고 있었다. 그러나, 이 논문이 나올 즈음 image texture에 대한 중요도에 대해서 연구가 제시되고 있었다.

CNN이 texture를 학습하는가, shape을 학습하는가에 대한 이 두가지 conflicting hypothesis에 대해서 quantitative test를 진행하였다.

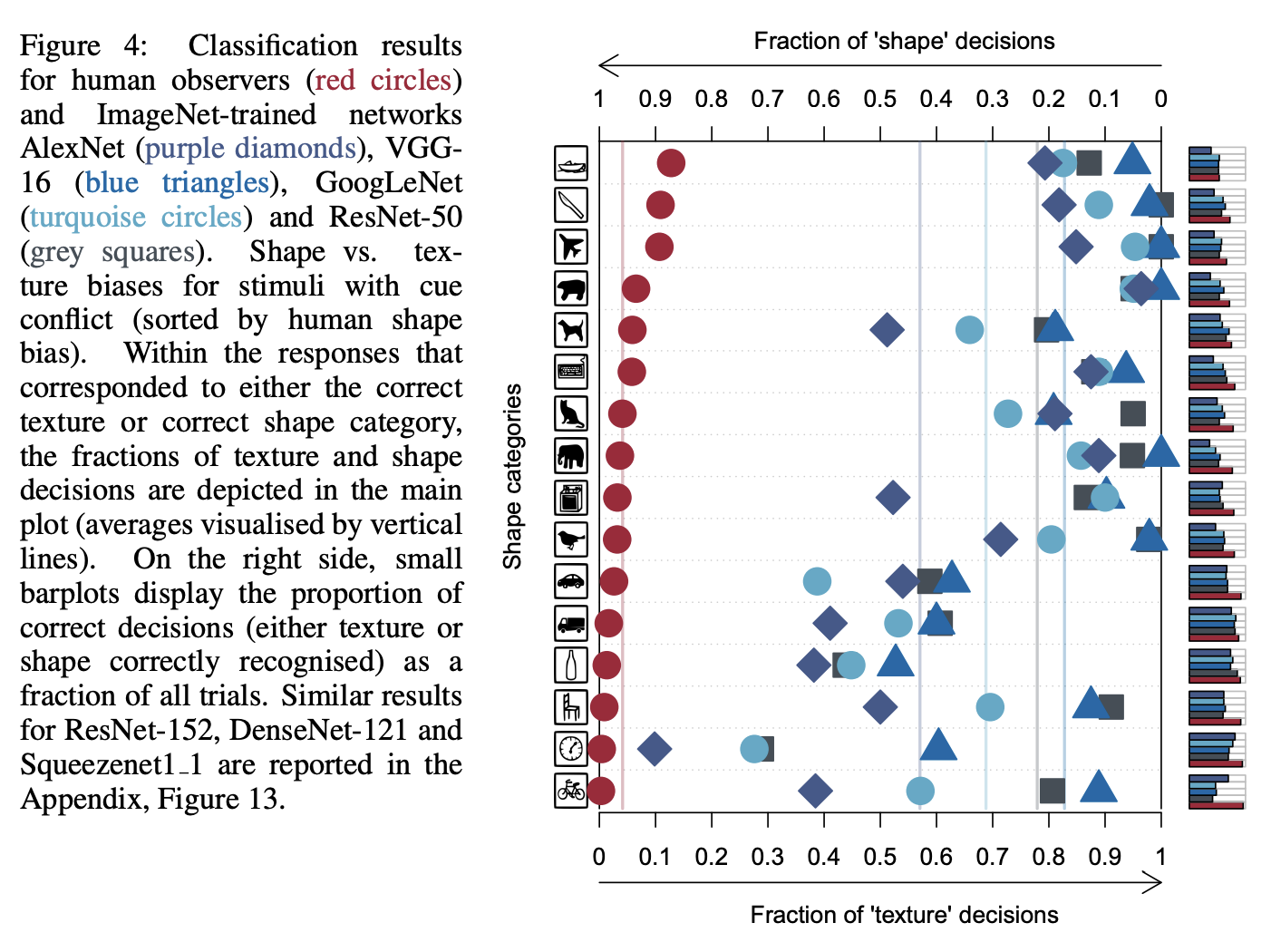

실험은 texture-shape cue conflict 이미지에 대해서 CNN과 human observers를 관찰하였다.

Figure 1 에서 볼 수 있듯이, Texture image는 texture에 대한 정보를 가지고 있는 이미지이고, Content image는 일반적인 content를 가지고 있는 shape image로 볼 수 있다. (c)에서 볼 수 있는 Texture-shape cue conflict image는 shape과 texture가 일치하지 않는 경우를 말한다. (c)에서 shape은 고양이이지만 texture는 코끼리이다. 이 때 ResNet-50은 이 이미지를 코기리로 분류한 것을 알 수 있다.

이 때까지 널리 알려진 가설은 shape hypothesis 였다.

shape hypothesis란 CNN은 low-level feature들을 조합해서 shape과 같은 복잡한 representation을 학습한다는 것이었다.

그러나 이를 반박하는 texture hypothesis가 제시되게 된다.

texture hypothesis란 기존의 common assumption인 shape hypothesis와는 달리 CNN이 object recognition을 할 때 global object shape보다 object texture를 더 중요시여긴다는 것이었다.

논문은 이 두가지 contradictory hypothesis 를 분석하였다.

간단하고 다양한 실험을 통해서 분석을 진행하였다.

이 논문에서는 CNN에서의 texture bias가 overcome될 수 있고, suitable dataset으로 학습된다면 shape bias로 바뀔 수 있다고 주장한다.

2. Method

ImageNet으로 pre-trained된 네가지 CNN(AlexNet, GooLeNet, VGG-16, ResNet-50)에 대해 같은 이미지를 입력으로 주었다.

WordNet hierarchy에 의해서 1000개의 ImageNet class를 16개의 categories에 mapping 하였다.

texture와 shape bias를 위해서 6개의 실험을 설계하였다.

1) original : 160 natural colour images of objects (10 per category) with white background이다.

2) grayscale : Original dataset에서 온 이미지이고 이를 grayscale로 변환한 것이다. 이 때 skimage.color.rgb2gray를 이용하였다.

3) Silhouette : Original dataset에서 온 이미지를 silhouette image로 변환한 것이다. object는 모두 검정색이고, background는 하얀색으로 표시된다.

4) Edges : Original dataset에서 온 이미지를 edge-based representation으로 변환시킨 것으로, Canny edge extractor를 이용하였다.

5) Texture : 48가지 natural color images of texture (3 per category)이다.

6) Cue conflict : Original dataset에서 온 이미지에서 texture와 image가 conflict되도록 한 generated image이다.

Stylized-ImageNet (SIN)

이 논문에서는 Stylized-ImageNet (SIN)이라는 새로운 dataset을 구성하였다. original image에서 texture를 제외시키고 AdaIN style transfer를 통해서 texture를 random하게 대체시켰다.

두가지 이유로 인해서 iterative stylization 대신에 AdaIN fast style transfer를 사용하였다.

1) 결과가 single stylization method에 의존되지 않게 하기 위해서

2) ImageNet 전체를 stylizing 하는데 iterative approach는 시간이 오래 걸리기 때문

3. Experiments

3.1. Texture vs Shape Bias in humans and imagenet-trained CNNs

대부분의 object and texture image는 CNN과 human 모두에게 올바르게 분류되었다.

- grayscale : 여전히 shape + texture에 대한 정보를 다 가지고 있다.

- silhouette : object는 black으로 칠해진다. 이 때 CNN은 사람에 비해서 accuracies가 많이 떨어진 것을 알 수 있다.

- edge stimuli : human이 texture에 대한 정보가 거의 없거나 존재하지 않는 경우에도 잘 판단하는 것을 알 수 있다.

- texture : human보다 CNN이 더 잘 판단한 것을 알 수 있다.

따라서, cue confict experiment를 고안하였다.

이 때 Human은 shape에 bias된 결과를 보여주었고, CNN들은 texture에 bias된 결과를 보여주었다.

VGG-16 : 17.2% shape vs. 82.8% texture

GoogLeNet : 31.2% vs.68.8%

AlexNet : 42.9% vs. 57.1%

ResNet-50 :22.1% vs. 77.9%

3.2. Overcoming the texture bias of CNNs

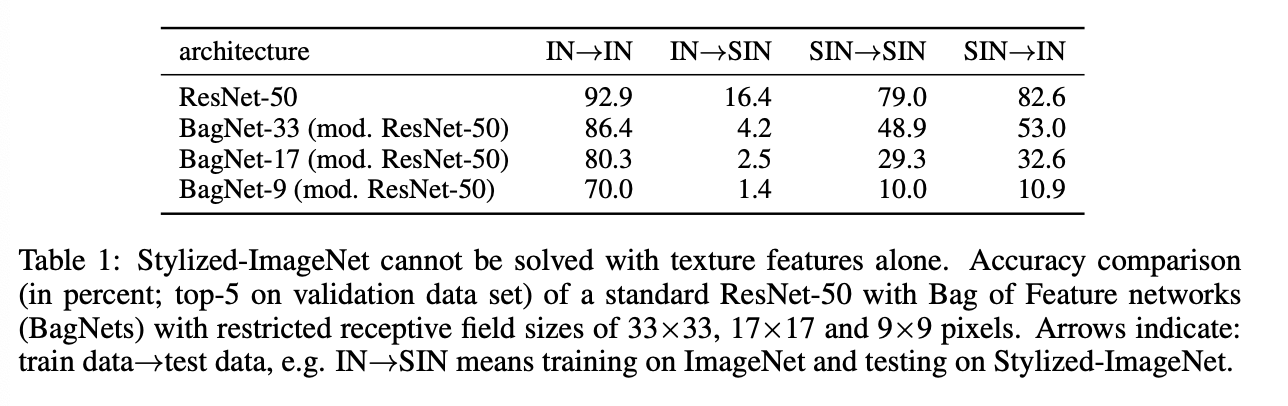

Brendel & Bethge(2019) 논문을 통해서, ImageNet은 only local information을 통해서만으로도 high accuracy를 찍은 것을 알 수 있었다. 이는 CNN이 전반적인 global shape이 아닌 local texture feature를 이용하는 것이 충분하다는 것을 말해준다.

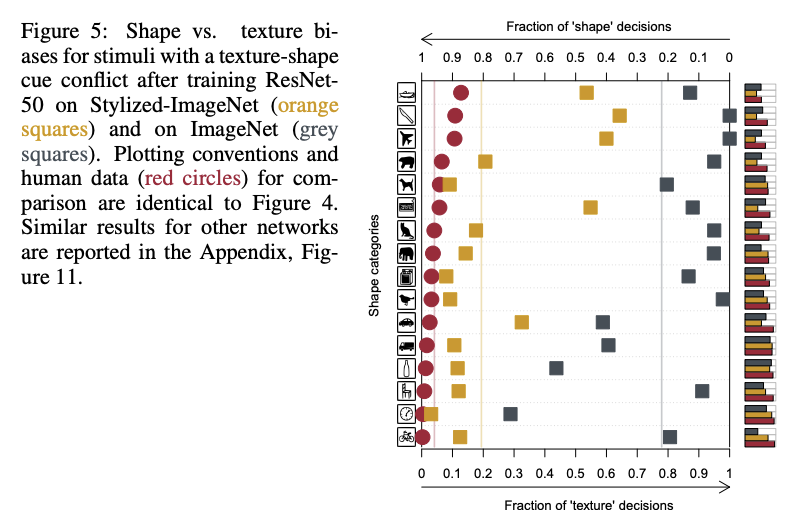

이 가설을 증명하기 위해서 ResNet-50을 SIN dataset에서 학습시켜보았다.

SIN에서 train되고 evaluate된 ResNet-50의 top-5 accuracy는 79.0%,

IN에서 train되고 evaluate된 ResNet-50의 top-5 accuracy는 92.9% 이다.

이는, SIN이 IN보다 더 어려운 task임을 의미한다. 외냐하면 texture가 no longer predictive하기 때문이다.

local texture feature가 여전히 SIN를 solve하기 위해서 충분하다는 것을 test하기 위해서, BagNets에서의 성능을 측정하였다.

BagNets는 ResNet-50 architecture를 가지고 있으나, maximum receptive field size 가 9x9, 17x17 or 33x33으로 제한된 것이다. 이 때의 성능을 보면, ImageNet은 70%, SIN에서는 10% 의 성능을 보여주고 있다. (receptive field size : 9x9 pixels)

이는 이들이 제안한 SIN dataset이 local texture cues를 확실하게 제거시켰으며, network가 long-range spatial information을 integrate한다는 것을 나타낸다.

SIN에 학습된 ResNet-50은 stronger shape bias를 보여주었다.

Stylized-ImageNet인 주황색 네모를 살펴보면 ImageNet의 경우보다 훨씬 더 shape bias하도록 학습된 것을 알 수 있다.

3.3. Robustness and accuracy of shape-based representations

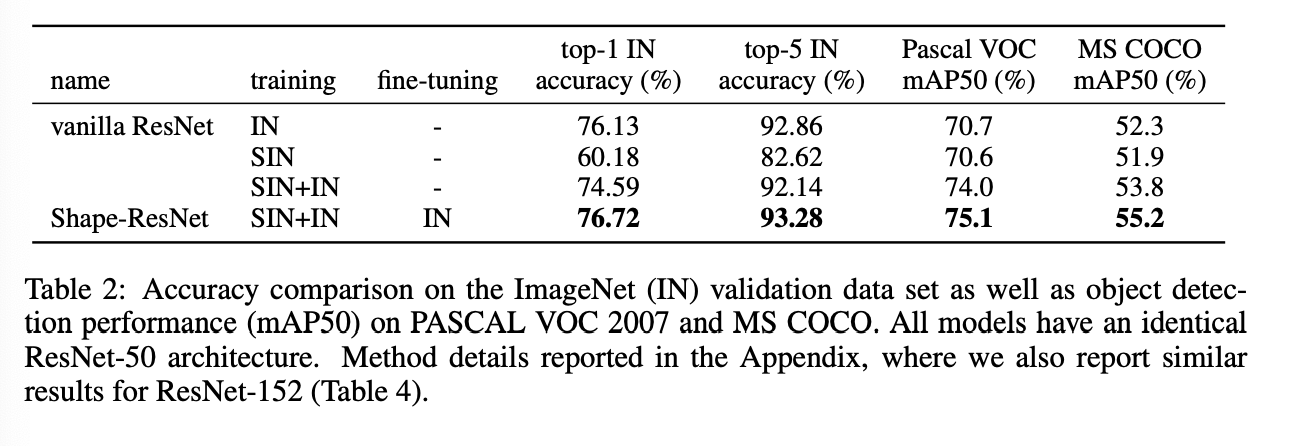

2가지 tarining schemes를 추가로 분석하였다.

1) training jointly on SIN and IN

2) training jointly on SIN and IN with fine-tuning on IN : Shape - ResNet

이 실험은 사람과 같이 shape bias를 증가시켰을 때 과연 성능과 robustness에 좋은 영향을 끼치는가에 대한 분석이다.

결과적으로 shape bias를 증가시킨 Shape-ResNet의 성능이 가장 좋은 것을 확인할 수 있었다.

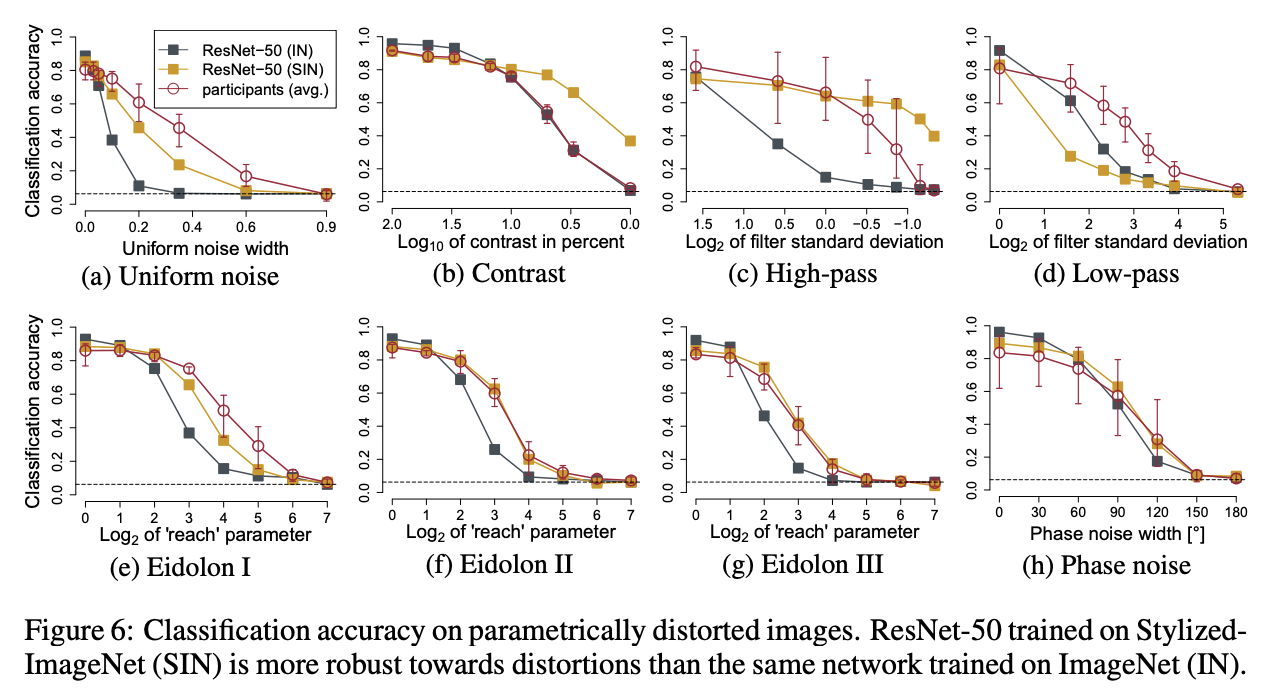

다음은 distortion에 대한 robustness이다.

같은 network를 ImageNet에 학습했을 때 보다 대부분의 distortion에 대해 더 robust한 것을 알 수 있다.

4. Conclusion

본 논문은 기존의 shape bias에 대한 통념을 반박하고 texture bias에 대해 분석한 논문으로, 추가적으로 shape biase되었을 때의 robustness 또한 증명해내었다.

5. Discussion

예전에 읽어보고 최근에 기회가 되어서 다시 한 번 읽어본 논문이다. 기존에 읽었을 때에는 CNN이 Texture bias된 것을 밝혀낸 논문이라는 것에 중점을 두고 읽었었는데, 이번에는 어떻게 Texture Bias라는 것을 증명해내었는지, 그리고 그것이 전반적인 CNN 성능을 높이기 위해서 어떻게 이용되었는지에 대해 중점을 두고 읽어보았다.

Texture Bias되었다는 것을 증명하고 사람과 같이 Shape bias 되어야만 더 성능과 robust해진다는 것 또한 밝혀내었다.

이를 통해서 Shape bias를 증가시키기 위한 새로운 데이터셋인 SIN을 제작하였고 CNN의 성능 높이기에 성공하였다.

통념에 대해 반박하는 논문이었기에 실험을 짠 논리에 대해 더 공부해볼 수 있었던 논문이다.